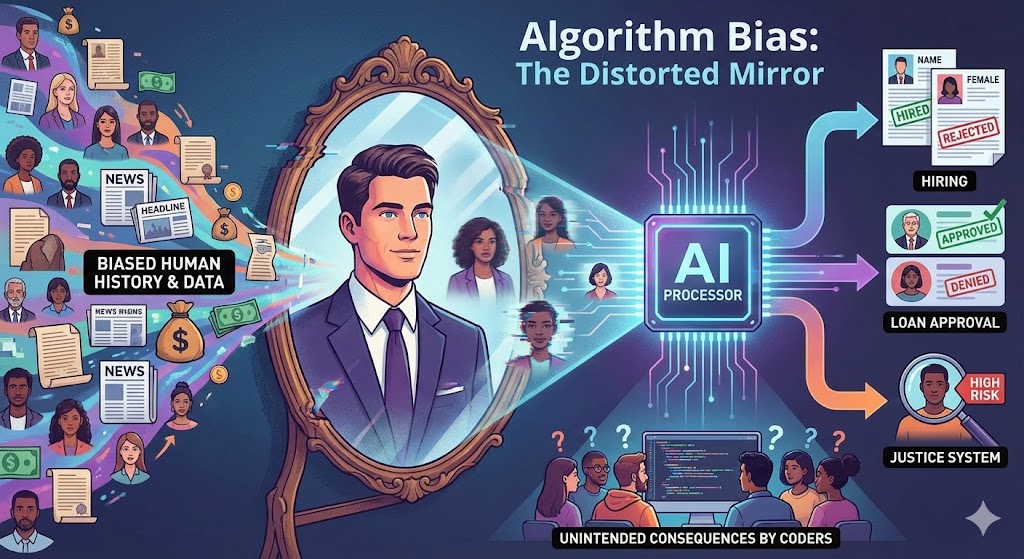

กระจกเงาที่บิดเบี้ยว เมื่อ AI “เลือกปฏิบัติ” โดยที่คนเขียนโค้ดไม่ได้ตั้งใจ

เรามักเชื่อกันว่า “ตัวเลขไม่เคยโกหก” และคอมพิวเตอร์คือสุดยอดแห่งความเป็นกลาง มันตัดสินใจทุกอย่างตามตรรกะ 0 และ 1 ปราศจากอารมณ์ ความรัก โลภ โกรธ หลง แบบมนุษย์

ความเชื่อนี้ทำให้เราเริ่มวางใจให้ปัญญาประดิษฐ์ (AI) และอัลกอริทึมเข้ามามีบทบาทในการตัดสินใจเรื่องสำคัญๆ ในชีวิตมากขึ้น ตั้งแต่เรื่องง่ายๆ ว่าเราควรดูหนังเรื่องอะไรใน Netflix ไปจนถึงเรื่องคอขาดบาดตาย เช่น ธนาคารควรอนุมัติเงินกู้ให้ใคร บริษัทควรรับใครเข้าทำงาน หรือแม้กระทั่งตำรวจควรเพ่งเล็งบุคคลใดเป็นพิเศษ

แต่จะเกิดอะไรขึ้น… ถ้าความเชื่อที่ว่า “AI เป็นกลาง” นั้นเป็นเรื่องเข้าใจผิด?

จะเกิดอะไรขึ้น ถ้าเครื่องจักรที่เราสร้างขึ้นมาเพื่อขจัดความลำเอียงของมนุษย์ กลับกำลังเรียนรู้และผลิตซ้ำอคติเหล่านั้น ทั้งการเหยียดเพศ เหยียดเชื้อชาติ หรือกีดกันกลุ่มคนชายขอบ โดยที่โปรแกรมเมอร์ผู้อยู่เบื้องหลังหน้าจอ ไม่ได้มีเจตนาให้เกิดขึ้นเลยแม้แต่นิดเดียว?

ปรากฏการณ์นี้เรียกว่า “Algorithm Bias” (อคติในอัลกอริทึม) และมันกำลังเป็นภัยเงียบที่คุกคามความยุติธรรมในสังคมยุคดิจิทัล

ต้นตอของปัญหา AI กินอะไรเข้าไป มันก็เป็นอย่างนั้น

ทำไมโปรแกรมเมอร์ที่รักความเท่าเทียม ถึงเขียนโค้ดที่เหยียดเชื้อชาติได้? คำตอบไม่ได้อยู่ที่ “เจตนา” แต่อยู่ที่ “วิธีการเรียนรู้” ของ AI ยุคใหม่

AI ในปัจจุบัน (โดยเฉพาะ Machine Learning) ไม่ได้รับคำสั่งแบบตายตัวว่า “ถ้าเจอ A ให้ทำ B” แต่พวกมันเรียนรู้ด้วยการหาแพทเทิร์นจากข้อมูลมหาศาลที่เราป้อนให้ เปรียบเสมือนเด็กทารกที่เรียนรู้โลกผ่านสิ่งที่ผู้ใหญ่สอน

ปัญหาคือ “ข้อมูล” ที่เราใช้สอน AI นั้น ไม่เคยสะอาดบริสุทธิ์

ข้อมูล (Data) คือการบันทึกประวัติศาสตร์ และประวัติศาสตร์ของมนุษย์นั้นเต็มไปด้วยความไม่เท่าเทียม การเลือกปฏิบัติ และอคติ หากเราป้อนข้อมูลในอดีตเข้าไป AI ก็จะเรียนรู้ว่า “อดีตคือสิ่งที่ถูกต้อง”

ตัวอย่างที่ 1: กับดักการจ้างงานของ Amazon

เมื่อหลายปีก่อน Amazon พยายามสร้าง AI เพื่อช่วยคัดกรองใบสมัครงาน โดยเทรนมันด้วยข้อมูลเรซูเม่ของผู้สมัครที่บริษัทได้รับในช่วง 10 ปีที่ผ่านมา

ผลปรากฏว่า… อุตสาหกรรมเทคโนโลยีในอดีต (และปัจจุบัน) มีผู้ชายเป็นส่วนใหญ่ ข้อมูลที่ AI ได้รับจึงมีแต่เรซูเม่ของผู้ชายที่ประสบความสำเร็จ AI จึงเรียนรู้แพทเทิร์นว่า “ผู้สมัครที่เป็นผู้ชายมักจะเป็นตัวเลือกที่ดีกว่า”

โดยที่ไม่ได้ตั้งใจ AI เริ่มปรับลดคะแนนเรซูเม่ที่มีคำว่า “Women’s” (เช่น “กัปตันทีมหมากรุกหญิง”) หรือเรซูเม่ที่มาจากวิทยาลัยหญิงล้วน โปรแกรมเมอร์ไม่ได้เขียนโค้ดให้เกลียดผู้หญิง แต่ AI เรียนรู้จากข้อมูลที่สะท้อนโลกแห่งความเป็นจริงที่บิดเบี้ยว

จุดบอดของผู้สร้าง (Blind Spots)

อีกสาเหตุหนึ่งที่ทำให้เกิด Algorithm Bias คือ “ความไม่หลากหลายของทีมผู้สร้าง”

หากทีมวิศวกรที่สร้างระบบจดจำใบหน้า (Facial Recognition) ประกอบไปด้วยผู้ชายผิวขาวเป็นส่วนใหญ่ พวกเขาก็จะใช้ภาพใบหน้าของตัวเองและคนรอบข้างในการทดสอบระบบเป็นหลัก

ผลที่ได้คือ AI ที่เก่งกาจในการแยกแยะใบหน้าชายผิวขาว แต่กลับล้มเหลวอย่างสิ้นเชิงเมื่อต้องระบุใบหน้าของผู้หญิงผิวดำ โดยมักจะระบุเพศผิด หรือจำไม่ได้เลย เพราะใน “ชุดข้อมูล” ที่มันเรียนรู้ มีตัวอย่างใบหน้ากลุ่มนี้น้อยเกินไป

กรณีศึกษาจาก Joy Buolamwini นักวิจัยจาก MIT Media Lab พบว่าระบบจดจำใบหน้าจากบริษัทยักษ์ใหญ่หลายแห่ง มีอัตราความผิดพลาดในการระบุเพศหญิงผิวเข้มสูงถึง 35% ในขณะที่ข้อผิดพลาดในกลุ่มชายผิวขาวมีไม่ถึง 1% นี่คือตัวอย่างที่ชัดเจนของการที่เทคโนโลยีทำงานได้ดีกับคนกลุ่มหนึ่ง แต่ล้มเหลวกับอีกกลุ่มหนึ่ง

ผลกระทบที่ตามมา การผลิตซ้ำความอยุติธรรม

เมื่อ AI ที่มีอคติถูกนำมาใช้งานจริง มันไม่ได้แค่สร้างความรำคาญ แต่มันส่งผลกระทบต่อชีวิตคนจริงๆ:

ด้านการเงิน: อัลกอริทึมประเมินเครดิตอาจปฏิเสธเงินกู้ของคนผิวดำหรือคนในพื้นที่ยากจนง่ายขึ้น เพียงเพราะข้อมูลในอดีตบอกว่าคนกลุ่มนี้มีความเสี่ยงสูง โดยไม่ดูปัจจัยส่วนบุคคลในปัจจุบัน

ด้านสุขภาพ: ในสหรัฐฯ เคยมีการใช้ AI จัดลำดับความสำคัญผู้ป่วยที่ควรได้รับการดูแลเป็นพิเศษ AI กลับให้ความสำคัญกับคนไข้ผิวขาวมากกว่าคนผิวดำ ทั้งที่ป่วยหนักเท่ากัน เหตุผลเพราะ AI ใช้ “ประวัติการใช้จ่ายค่ารักษาพยาบาลในอดีต” เป็นตัวชี้วัด และคนผิวดำในอดีตมีข้อจำกัดในการเข้าถึงบริการราคาแพง AI จึงสรุปเอาเองว่าพวกเขาป่วยน้อยกว่า

ด้านกระบวนการยุติธรรม: ซอฟต์แวร์ช่วยตำรวจคาดการณ์อาชญากรรม อาจส่งตำรวจไปตรวจตราในย่านคนจนหรือย่านคนผิวสีถี่ขึ้น เพราะข้อมูลสถิติการจับกุมในอดีตกระจุกตัวอยู่ที่นั่น ซึ่งยิ่งทำให้เกิดการจับกุมในพื้นที่เดิมๆ วนเวียนเป็นวงจรอุบาทว์

ทางออก: ยอมรับว่ากระจกมันเบี้ยว แล้วเริ่มขัดมัน

การแก้ปัญหา Algorithm Bias ไม่ใช่การเลิกใช้ AI แต่คือการยอมรับความจริงว่า AI ไม่ได้เป็นกลาง และเราต้องรับผิดชอบสิ่งที่มันทำ

สร้างทีมที่หลากหลาย (Diversity is Key): นี่ไม่ใช่แค่เรื่องความถูกต้องทางการเมือง แต่เป็นความจำเป็นทางเทคนิค หากทีมสร้างมีทั้งผู้หญิง คนหลากเชื้อชาติ และคนหลายสถานะ พวกเขาจะช่วยกันมองเห็น “จุดบอด” ที่อีกฝ่ายมองไม่เห็นได้ง่ายขึ้น

ตรวจสอบข้อมูล (Data Auditing): ก่อนจะป้อนข้อมูลให้ AI ต้องมีการทำความสะอาดและตรวจสอบข้อมูลอย่างละเอียดว่ามีการกระจายตัวที่เป็นธรรมหรือไม่ และต้องตัดตัวแปรที่อาจนำไปสู่การเลือกปฏิบัติออก (เช่น บางกรณีอาจต้องตัดรหัสไปรษณีย์ออก เพราะมันบ่งบอกถึงฐานะและเชื้อชาติได้)

AI ที่อธิบายได้ (Explainable AI – XAI): เราต้องเลิกสร้าง AI ที่เป็น